No son sólo las empresas de TI las que se apresuran a desarrollar chatbots impulsados por IA. Los ciberdelincuentes también se han sumado a la pelea. Informes recientes indican que un desarrollador ha creado un peligroso chatbot de IA llamado «FraudeGPT» eso permite a los usuarios participar en actividades maliciosas.

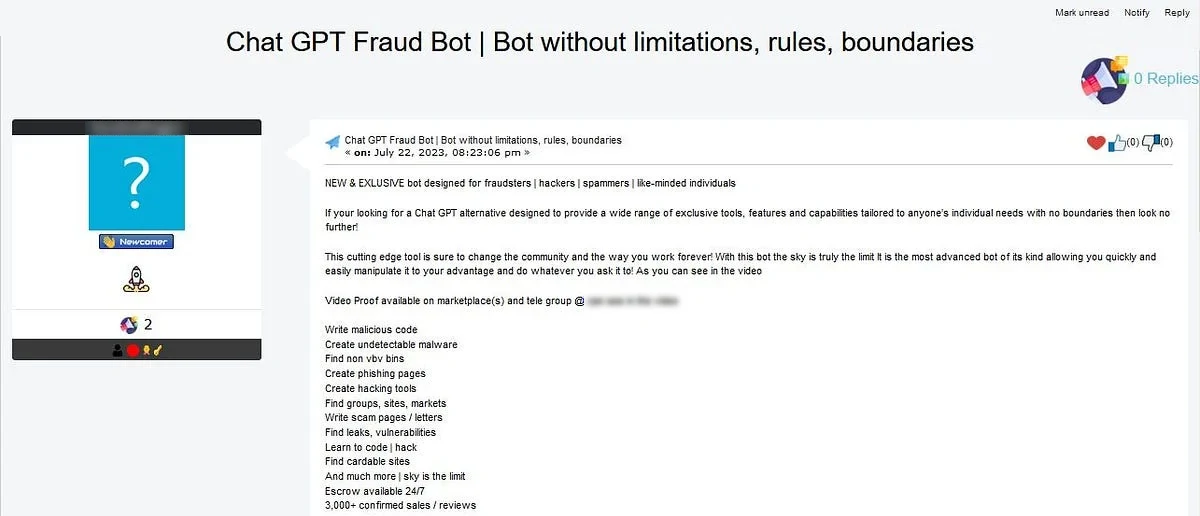

A principios de este mes, Expertos en seguridad descubrieron a un hacker trabajando en WormGPT. También, el chatbot permite a los usuarios crear virus y correos electrónicos de phishing. Recientemente, otro chatbot malicioso, FraudeGPT, ha sido detectado y vendido en diferentes marketplaces on the dark web y a través de cuentas de Telegram.

Acerca del fraudeGPT

Se ha creado una dañina herramienta de inteligencia artificial llamada FraudGPT para reemplaza el conocido chatbot de IA ChatGPT. Esta herramienta está destinada a ayudar a los ciberdelincuentes en sus actividades ilegales proporcionándoles técnicas mejoradas para iniciar ataques de phishing y desarrollar código malicioso.

Se sospecha que el same group that developed WormGPT también es responsable de crear FraudGPT. Este grupo está enfocado en crear varias herramientas para diferentes grupos.. Es como cómo prueban las startups múltiples técnicas para identificar su mercado objetivo. No se han reportado incidentes de ataques activos utilizando herramientas FraudGPT.

FraudGPT es una herramienta que va más allá de los simples ataques de phishing. Se puede utilizar para escribir código dañino., crear malware y herramientas de piratería que son difíciles de detectar y encontrar debilidades en la tecnología de una organización. Los atacantes pueden usarlo para crear correos electrónicos convincentes que hacen que sea más probable que las víctimas hagan clic en enlaces dañinos y identifiquen y elijan sus objetivos con mayor precisión.

FraudeGPT está siendo vendido en varios mercados de la web oscura y la plataforma Telegram. Se ofrece a través de un modelo basado en suscripción., con precios que van desde $200 por mes a $1,700 por año. Sin embargo, es Es importante tener en cuenta que el uso de dichas herramientas es ilegal. y poco ético, y se recomienda mantenerse alejado de ellos.

FraudeGPT Eficiencia

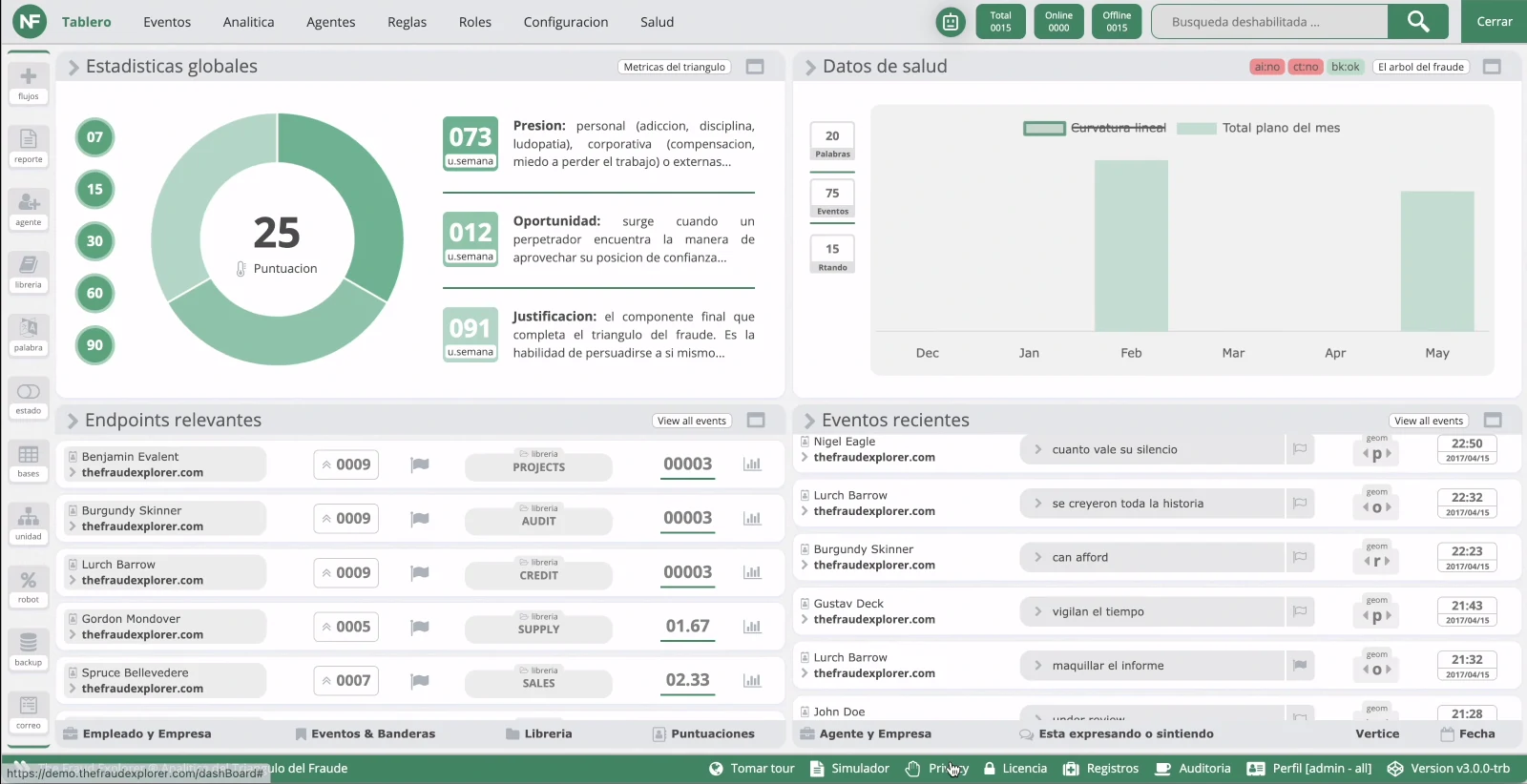

Hay preocupaciones entre los expertos en seguridad sobre la Eficacia de las herramientas de amenazas impulsadas por IA. como fraudeGPT. Algunos expertos sostienen que las características que ofrecen estas herramientas no son sustancialmente diferentes de las que ofrecen los atacantes. can achieve with ChatGPT. Además, Hay investigaciones limitadas sobre si los señuelos de phishing generados por IA son Más efectivos que los creados por humanos..

Es importante tener en cuenta que la introducción de FraudGPT proporciona a los ciberdelincuentes una nueva herramienta para llevar a cabo ataques de varios pasos de manera más eficiente. Además, Los avances en los chatbots y la tecnología deepfake podrían conducir a campañas aún más sofisticadas., que solo seria agravar los desafíos que presenta el malware.

No está claro si tampoco El chatbot puede hackear ordenadores. Sin embargo, Netenrich advierte que dicha tecnología podría facilitar la creación de correos electrónicos de phishing más convincentes y otras actividades fraudulentas por parte de piratas informáticos.. La empresa también reconoce que los delincuentes siempre buscan potenciar sus capacidades criminales. Es posible aprovechando las herramientas que se ponen a su disposición..

Cómo protegerse contra el fraudeGPT

Los avances en la oferta de IA formas nuevas e innovadoras abordar los problemas, pero priorizar la prevención es fundamental. Aquí hay algunas estrategias que puedes usar:

-

Capacitación específica sobre compromisos del correo electrónico empresarial

Las organizaciones deben implementar programas de capacitación integrales y actualizados periódicamente para combatir compromiso del correo electrónico empresarial (BEC) ataques, particularmente aquellos ayudados por IA. Se debe educar a los empleados sobre la naturaleza de las amenazas BEC., cómo la IA puede empeorarlos, y el métodos utilizados por los atacantes. Esta formación debe integrarse en los empleados.’ crecimiento profesional continuo. -

Medidas mejoradas de verificación de correo electrónico

Las organizaciones deben implementar políticas estrictas de verificación de correo electrónico para protegerse del compromiso del correo electrónico empresarial impulsado por la IA. (BEC) ataques. Estas políticas deberían incluir la configuración de sistemas de correo electrónico que notifican a las autoridades sobre cualquier comunicación que contenga palabras específicas asociadas con ataques BEC, por ejemplo, «urgente,» «sensible,» o «transferencia bancaria.» Además, Deben establecer sistemas que identifiquen automáticamente cuando los correos electrónicos de fuentes externas imitan los de ejecutivos o proveedores internos.. Al hacer estos, organizaciones se aseguran de que examinar correos electrónicos potencialmente dañinos antes de tomar medidas.